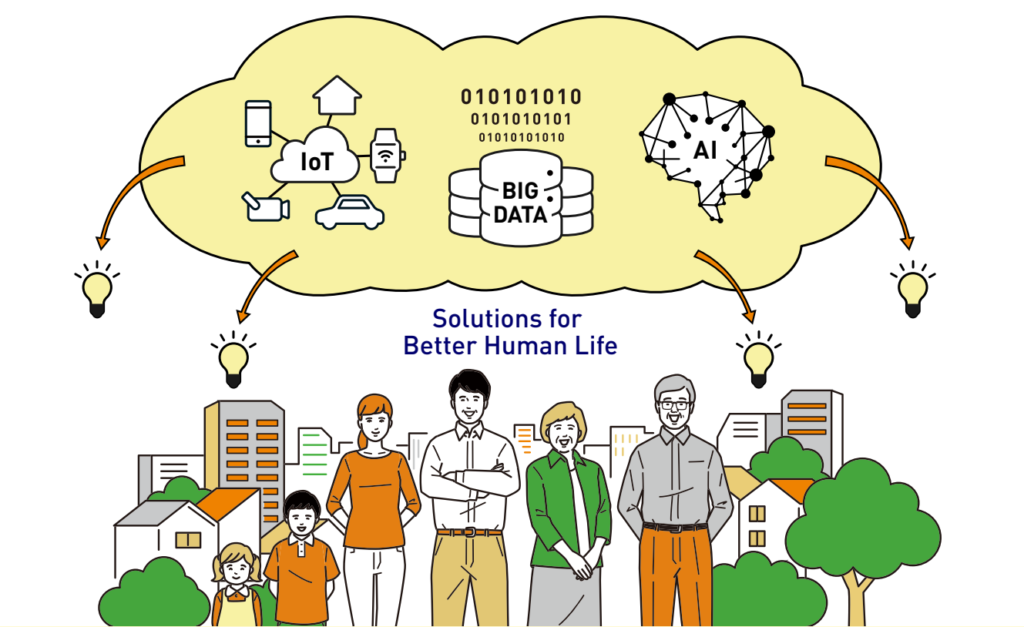

Idea Society 5.0 polega na stworzeniu superinteligentnego społeczeństwa, w którym różne społeczne wyzwania rozwiązywane są poprzez wdrożenie innowacji czwartej rewolucji przemysłowej – takich jak: IoT, Big Data, Sztuczna Inteligencja (AI), robotyka czy ekonomia współdzielenia – do każdej branży oraz w życie społeczne. W tak wyglądającym świecie, ludzie, maszyny oraz ich otoczenie, są ze sobą połączone i potrafią komunikować się między sobą [1]. W praktyce, Społeczeństwo 5.0 będzie m.in. dążyło do zapewnienia lepszej opieki seniorom. Na przykład w Japonii społeczeństwo starzeje się bardzo szybko. Jeśli kiedykolwiek w przyszłości miałoby zabraknąć rąk do zajmowania się osobami starszymi, to właśnie nowa jakość przetwarzania danych będzie w stanie podnieść standard opieki zdrowotnej dla emerytów [2]. Społeczeństwo 5.0 to termin odnoszący się do nowej idei społeczeństwa. W takiej koncepcji rozwój technologiczny koncentruje się na człowieku i poszukuje wartościowych rozwiązań dla życia ludzi na całym świecie.

Rys. 1. Ilustracja przedstawiająca plan transformacji społecznej Japonii – Society 5.0.

Źródło: https://www.japan.go.jp/abenomics/_userdata/abenomics/pdf/society_5.0.pdf

[Dostęp: 07.03.2024]

Historia rozwoju społeczeństwa

Społeczeństwo 5.0 jest wynikiem niczego innego, jak ewolucji obejmującej pięć etapów rozwoju społecznego:

- Society 1.0: Społeczeństwo zbieracko-łowieckie (sposób życia pierwszych ludzi, trwał do około 12 000 lat temu) – społeczeństwo, które swój styl życia opiera na polowaniu i łowieniu zwierząt oraz poszukiwaniu dzikiej roślinności i innych rodzajów składników odżywczych [3].

- Society 2.0: Społeczeństwo rolnicze (pierwszy raz pojawia się około 10 000 – 8 000 lat temu) – społeczeństwo, które koncentruje swoją gospodarkę przede wszystkim na rolnictwie i uprawie dużych pól [4].

- Society 3.0: Społeczeństwo przemysłowe (od końca XVIII wieku) – społeczeństwo, w którym dominującym sposobem organizacji życia są technologie produkcji masowej, wykorzystywane do wytwarzania ogromnych ilości towarów w fabrykach [5].

- Society 4.0: Społeczeństwo informacyjne (od drugiej połowy XX wieku) – społeczeństwo, w którym tworzenie, rozpowszechnianie, wykorzystywanie, integrowanie i zarządzanie informacją jest istotnym aspektem działalności gospodarczej, politycznej czy kulturalnej [6].

Integracja technologiczna dla lepszej jakości życia

Koncepcja zbierania danych z otaczającego nas świata, przetwarzania ich przez komputery oraz wykorzystywania ich w praktyce nie jest w dzisiejszym świecie nowością. Na dokładnie takiej zasadzie oparte jest działanie, przykładowo, klimatyzatorów. Regularnie wykonują one pomiar temperatury w pomieszczeniu, a następnie porównują odczyt z wcześniej zaprogramowaną temperaturą. W zależności od tego, czy zmierzona temperatura jest większa, czy mniejsza od pierwotnie ustawionej, urządzenie wstrzymuje lub uruchamia przepływ powietrza. Mechanizm ten wykorzystuje zautomatyzowane systemy komputerowe. Termin „społeczeństwo informacyjne” (Society 4.0) odnosi się zatem do społeczeństwa, w którym każdy z takich systemów pozyskuje dane, przetwarza je, a następnie wykorzystuje w swoim własnym, sprecyzowanym środowisku.

Wiedząc już dokładnie, na czym polega idea Społeczeństwa 4.0, możemy zrozumieć, co w istocie odróżnia je od Społeczeństwa 5.0. Zasadnicza różnica polega na tym, że Society 5.0 zamiast wykorzystywać systemy działające w zdefiniowanym, ograniczonym zakresie, wykorzystywać będzie takie, które funkcjonują w zintegrowany sposób, wpływając przy tym na życie całego społeczeństwa. Dane przetwarzane będą przez zaawansowane systemy informatyczne, takie jak Sztuczna Inteligencja. Systemy te przystosowane są do przetwarzania tak dużej ilości danych. Głównym celem wykorzystania gromadzonych danych będzie zapewnienie wszystkim szczęścia oraz komfortu [7]. W BFirst.Tech również widzimy te potrzeby i odpowiadamy na nie stosując konkretne narzędzia. Nasze obszary – Data Engineering oraz Data Architecture & Management wykorzystują innowacyjne rozwiązania technologiczne do zbierania, analizowania i zarządzania danymi, aby wspierać efektywne i zrównoważone gospodarowanie procesami. Taki sposób gospodarowania ma istotny wpływ na bezpieczeństwo, wiarygodność danych oraz strategiczne podejmowanie decyzji. Przyczynia się to do wzrostu dobrobytu w społeczeństwie.

Nowa era dobrobytu a stojące przed nią wyzwania

Społeczeństwo 5.0 ma za cel wykorzystanie najnowocześniejszych technologii w taki sposób, aby zapewnić dobrobyt wszystkim ludziom. Idea ta zakłada, że rozwój technologiczny może być narzędziem do przeciwdziałania nierównościom społecznym, poprawy jakości życia oraz stworzenia bardziej zrównoważonej społeczności. Główne cele, jakich realizację przewiduje, to:

- zmniejszenie nierówności społecznych,

- przyspieszenie usług medycznych oraz zwiększenie precyzji zabiegów i operacji,

- zwiększenie produkcji żywności przy jednoczesnej redukcji marnotrawstwa

- poprawa bezpieczeństwa publicznego,

- rozwiązywanie problemów spowodowanych katastrofami naturalnymi,

- promowanie uczestnictwa społeczeństwa w opracowywaniu pomysłów i projektów,

- zapewnienie transparentnego dostępu do danych oraz utrzymanie bezpieczeństwa informacji.

Społeczeństwo 5.0 stawia sobie za cel stworzenie harmonijnej równowagi między rozwojem technologicznym a potrzebami społecznymi. Niesie to jednak ze sobą swoje wyzwania. Jednym z najbardziej istotnych warunków do skutecznego wdrożenia tej wizji jest zaangażowanie oraz przywództwo rządów. Jest tak, ponieważ to rządy odpowiedzialne są za aspekty takie jak finansowanie, wdrażanie technologii w życie publiczne czy tworzenie nowych przepisów związanych z bezpieczeństwem. Kolejne istotne wyzwanie stanowią ryzyka związane z cyberbezpieczeństwem. Należy mieć na uwadze, że działania hackerów, czy też kwestie związane z kradzieżą danych, mogą skutecznie zahamować rozwój innowacji, dlatego kluczowe jest zadbanie o należyty poziom ochrony danych [8].

Cele Zrównoważonego Rozwoju Organizacji Narodów Zjednoczonych

Społeczeństwo 5.0 oraz Cele Zrównoważonego Rozwoju Organizacji Narodów Zjednoczonych to dwie, oddzielne inicjatywy, które zmierzają w bardzo podobnym kierunku. Te dwa innowacyjne podejścia dzielą bowiem jeden wspólny cel – eliminowanie problemów społecznych w zrównoważony sposób. Można powiedzieć, że Society 5.0 w pewien sposób realizować będzie Cele Zrównoważonego Rozwoju, poprzez określone działania. Te działania, zestawione z konkretnymi celami, to:

- dążenie do dokładniejszego oraz skuteczniejszego diagnozowania chorób poprzez wykorzystanie zaawansowanych technologii (takich jak Big Data czy Sztuczna Inteligencja),

Rys. 2. Ilustracja przedstawiająca 3. cel zrównoważonego rozwoju ONZ.

Źródło: https://www.un.org.pl/download

- upowszechnianie e-learningu oraz zapewnianie większej dostępności edukacji,

Rys. 3. Ilustracja przedstawiająca 4. cel zrównoważonego rozwoju ONZ.

Źródło: https://www.un.org.pl/download

- tworzenie nowych miejsc pracy związanych z dziedzinami takimi jak robotyka, Sztuczna Inteligencja czy analiza danych,

Rys. 4. Ilustracja przedstawiająca 8. cel zrównoważonego rozwoju ONZ.

Źródło: https://www.un.org.pl/download

- promowanie innowacji oraz inwestowanie w nową infrastrukturę (taką jak inteligentne sieci czy szybki Internet),

Rys. 5. Ilustracja przedstawiająca 9. cel zrównoważonego rozwoju ONZ.

Źródło: https://www.un.org.pl/download

- tworzenie inteligentnych miast, które wykorzystują czujniki i analizę danych w celu optymalizacji przepływu ruchu, zmniejszenia zużycia energii oraz poprawy bezpieczeństwa,

Rys. 6. Ilustracja przedstawiająca 11. cel zrównoważonego rozwoju ONZ.

Źródło: https://www.un.org.pl/download

- redukowanie emisji gazów cieplarnianych oraz promowanie zrównoważonego transportu.

Rys. 7. Ilustracja przedstawiająca 13. cel zrównoważonego rozwoju ONZ.

Źródło: https://www.un.org.pl/download

Wspólny kierunek

Niezwykle istotne jest, aby korzyści wynikające z idei Society 5.0 były równo dostępne dla każdego, tak, aby wszyscy mieli taką samą szansę skorzystania z jej potencjału. Tylko dzięki takiemu podejściu udział Społeczeństwa 5.0 w realizowaniu Celów Zrównoważonego Rozwoju ma szansę na efektywny rezultat [9]. BFirst.Tech jako partner merytoryczny United Nations Global Compact Network Poland (UN GCNP) również dba o realizację Celów Zrównoważonego Rozwoju. W obszarach, które skupiają się na przetwarzaniu, projektowaniu i zarządzaniu danymi, czyli Data Engineering oraz Data Architecture & Management, nasza firma wciela w życie cele, pokrywające się z celami uskutecznianymi przez Society 5.0, takie jak: Cel 9 – w zakresie zabezpieczania, agregowania i analizy dużych zbiorów danych, optymalizacji oraz zarządzania i kontroli jakości procesów z wykorzystaniem AI; Cel 11 – w zakresie zabezpieczania kluczowych informacji mających wpływ na poprawę warunków życia mieszkańców miast; oraz Cel 13 – w zakresie zmniejszania zużycia zasobów i emisji odpadów poprzez zwiększanie efektywności produkcji.

Zmiany wpływające na wiele obszarów

Dzięki wdrożeniu koncepcji Society 5.0 możliwa jest modernizacja wielu różnych płaszczyzn życia społecznego. Jedną z nich jest wspominana wcześniej opieka zdrowotna. W obliczu starzejącego się społeczeństwa Japonii, kraj ten zmaga się obecnie ze wzrastającymi wydatkami oraz potrzebą opieki nad seniorami. Społeczeństwo 5.0 rozwiązuje ten problem, poprzez wprowadzenie Sztucznej Inteligencji. Gromadzi ona, a następnie analizuje dane dotyczące pacjenta, co zapewnia najwyższy poziom diagnostyki oraz leczenia. Z kolei zdalne konsultacje medyczne wpływają pozytywnie na wygodę osób starszych. Zapewnia im to możliwość kontaktu z lekarzem nawet z własnego miejsca zamieszkania.

Kolejną płaszczyznę stanowi mobilność. Większość obszarów wiejskich Japonii nie ma dostępu do transportu publicznego. Wpływ na to ma między innymi spadek liczby ludności przyczyniający się do coraz słabszego zaludnienia tych obszarów. Problem stanowi również narastający brak kierowców, związany z ciągle rozwijającym się sektorem e-commerce. Rozwiązaniem, jakie proponuje na te kwestie Society 5.0, jest wdrożenie autonomicznych pojazdów, takich jak taksówki czy autobusy. Warto wspomnieć również o obszarze infrastruktury. W Społeczeństwie 5.0 to czujniki, Sztuczna Inteligencja oraz roboty będą autonomicznie kontrolować i konserwować drogi, tunele, mosty oraz tamy. Ostatni już obszar warty uwagi stanowią technologie finansowe (FinTech). W Japonii w dalszym ciągu większość transakcji pieniężnych odbywa się za pomocą gotówki bądź procedur bankowych. Potrafi to trwać znacząco zbyt długo. Społeczeństwo 5.0 proponuje zaimplementowanie technologii Blockchain do transakcji pieniężnych oraz wprowadzenie powszechnych, dostępnych wszędzie płatności za pośrednictwem smartfona [10].

Podsumowanie

Society 5.0 to koncepcja społeczeństwa, które wykorzystuje zaawansowane technologie, aby stworzyć społeczeństwo oparte na zrównoważonym rozwoju, innowacjach społecznych oraz cyfrowej transformacji. Celem Society 5.0 jest nie tylko osiągnięcie wzrostu gospodarczego, ale także poprawa jakości życia obywateli. Za rozwojem tej idei stoją również pewne wyzwania. Są one związane przede wszystkim z bezpieczeństwem danych, czy też wprowadzaniem odpowiednich regulacji zapewniających płynną oraz komfortową dla wszystkich transformację. Society 5.0 w dużym stopniu dzieli wizję przyszłości z Celami Zrównoważonego Rozwoju (SDG), ogłoszonymi przez Organizację Narodów Zjednoczonych. Wiele z nich można osiągnąć poprzez wdrażanie tej koncepcji. Społeczeństwo 5.0 obejmuje szeroki zakres obszarów życia społecznego, w tym opiekę zdrowotną, mobilność, infrastrukturę oraz technologie finansowe. Dzięki wykorzystaniu zaawansowanych technologii w tych dziedzinach, dąży się do stworzenia zrównoważonego i innowacyjnego społeczeństwa, które będzie miało pozytywny wpływ na jakość życia obywateli.

Bibliografia

[1] https://www.japan.go.jp/abenomics/_userdata/abenomics/pdf/society_5.0.pdf [Dostęp: 07.03.2024]

[2] https://sektor3-0.pl/blog/japonski-czlowiek-nowej-ery-czyli-spoleczenstwo-5-0/

[3] https://education.nationalgeographic.org/resource/hunter-gatherer-culture/

[4] https://www.thoughtco.com/agrarian-society-definition-3026047

[5] https://www.thoughtco.com/industrial-society-3026359

[6] https://www.techtarget.com/whatis/definition/Information-Society

[7] Atsushi Deguchi, Chiaki Hirai, Hideyuki Matsuoka, Taku Nakano, Kohei Oshima, Mitsuharu Tai, Shigeyuki Tani „What is Society 5.0?”

[8] https://www.sydle.com/blog/society-5-0-5fc163e1725a642683ed9230

[10] https://medium.com/@jacobprakoso/japan-super-smart-society-5-0-9b9e8ba49a7