Rozpoczęta w latach 90. XX wieku komputeryzacja wprowadziła ludzkość w epokę, w której praca i codzienne obcowanie z technologią jest powszechne i naturalne. Sztuczna Inteligencja odpowiada na nasze pytania, a Internet postrzegany jest jako nieskończone źródło informacji. Choć można pomyśleć, że rozwój technologii pomaga nam w zrozumieniu otaczającego świata, istnieją zjawiska pokazujące, jak często nasze intuicje zawodzą. Technologie, na pierwszy rzut oka proste i oczywiste, potrafią skrywać paradoksy i złudzenia, których dostrzeżenie, jak i zrozumienie, może być trudniejsze niż się wydaje. Artykuł ten przybliży trzy ciekawe zjawiska: efekt Elizy, paradoks Moraveca oraz efekt Streisand. Każde z nich pokazuje, w jaki sposób technologia może zmieniać naszą percepcję rzeczywistości, wpływając na to jak widzimy maszyny, dane i informacje. Poznanie tych zjawisk pozwoli spojrzeć z innej strony na rozwój technologii oraz pomoże bardziej świadomie z niej korzystać.

Efekt Elizy

W latach 60-tych XX wieku Joseph Weizenbaum w Massachusetts Institute of Technology napisał program ELIZA [1]. Program ten był jednym z pierwszych chatbotów – w naturalny sposób naśladował zwykłą konwersację. Mimo prostoty algorytmu, który na podstawie wprowadzanych słów kluczowych tworzył odpowiedzi działając zgodnie z ustalonymi z góry schematami, wielu użytkowników programu zgłaszało, iż odnoszą wrażenie, że Eliza naprawdę ich rozumie. Dzięki sprytnemu doborowi odpowiedzi, użytkownicy potrafili być mocno zaangażowani w rozmowę, zadowoleni faktem, iż rozmówca rozumie i słucha. Sam twórca był zaskoczony, jak bardzo ludzie byli przekonani, że Eliza jest człowiekiem, nie maszyną.

Właśnie od tego chatbota wziął swoją nazwę efekt Elizy – zjawisko skłonności do przypisywania przez człowieka maszynom, programom (w tym Sztucznej Inteligencji) zdolności do rozumienia, empatii i inteligencji, czyli ich antropomorfizacji [2]. Wśród przykładów tego zjawiska można wymienić wyświetlanie komunikatów “witaj” czy “dziękuję” przez bankomaty i kasy samoobsługowe, które są predefiniowanymi tekstami do wyświetlenia, a nie wyrazem wdzięczności maszyny; czy komunikacja z asystentami głosowymi – dziękowanie im, mówienie “ona” o asystencie Alexa, która mimo używania żeńskiego głosu w dalszym ciągu pozostaje bezpłciowym algorytmem. Podstaw tego efektu można doszukiwać się w naszej naturze – to co ludzkie wydaje się znajome, bliższe, mniej straszne, co widać chociażby w sposobie przedstawiania dawnych bóstw i porównywaniu ich do ludzi i zwierząt, przypisywaniu im zjawisk pogodowych czy żywiołów [3].

Takie spoufalanie się z – nieraz bardzo skomplikowanymi – technologiami pozwala na przełamanie obaw przed nowościami, zachęca do interakcji i buduje przywiązanie do używanego produktu. Jednocześnie efekt ten może powodować przecenienie zdolności danego algorytmu (ze względu na założenie, że maszyna wie i rozumie więcej niż w rzeczywistości), nadmierną ufność w otrzymywane informacje, czy niezdrowe do granic traktowanie tworu jak ludzkiej istoty, np. przez traktowanie chatbota jak terapeuty czy zawieranie ślubów z AI [4].

Paradoks Moraveca

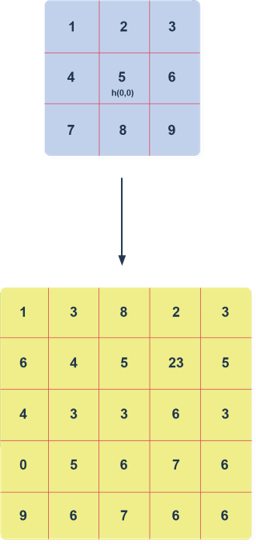

Kolejne interesujące zjawisko wzięło swoją nazwę od nazwiska kanadyjskiego naukowca, Hansa Moraveca, autora prac w dziedzinie technologii, futurologii i transhumanizmu. We współpracy z Rodney’em Brooksem oraz Marvinem Minskym w 1988 roku sformułował stwierdzenie: „Stosunkowo łatwo sprawić, żeby komputery przejawiały umiejętności dorosłego człowieka w testach na inteligencję albo w grze w warcaby, ale jest trudne albo wręcz niemożliwe zaprogramowanie im umiejętności rocznego dziecka w percepcji i mobilności” [5]. Oznacza ono, że zadania uważane za trudne, wymagające wiedzy, inteligencji i logicznego myślenia, są stosunkowo proste do rozwiązania z wykorzystaniem Sztucznej Inteligencji, natomiast te czynności, które uważamy za proste i naturalne – chodzenie, rozpoznawanie twarzy i przedmiotów czy koordynacja ruchowa – są bardzo problematyczne i trudne do zaimplementowania w maszynach.

Naukowcy doszukują się wyjaśnienia tego paradoksu w procesie ewolucji człowieka. Zdolności motoryczne człowieka rozwijały się przez miliony lat, były niezbędne do przetrwania oraz powoli, lecz ciągle poprawiane za sprawą selekcji naturalnej. Ludzki mózg miał dużo czasu na przyswojenie i zaadaptowanie się do czynności takich jak chwytanie narzędzi, rozpoznawanie twarzy i emocji, chodzenie czy koordynacja ruchowa, dlatego są one zautomatyzowane na głębokim poziomie, wykonujemy je bez świadomego wysiłku. Z kolei abstrakcyjne myślenie, matematyka, logika to zdolności stosunkowo nowe, nie zakorzenione tak głęboko i wymagające świadomego wysiłku intelektualnego. Z racji tego, że te zdolności nie są zakorzenione w ludziach tak głęboko, łatwiej jest zastosować w ich przypadku inżynierię wsteczną i zaimplementować je w postaci programu. Ponadto komputery są najbardziej skuteczne w odwzorowywaniu procesów logicznych, schematycznych, z określonymi krokami. Z tych powodów mamy już programy wybitne, w porównaniu do ludzi, jeśli chodzi o złożone obliczenia, szachy, symulacje, jednak, jeśli chodzi o mobilność, koordynację, rozpoznawanie obiektów i twarzy, czy inne “podstawowe” czynności, które uznajemy za naturalne i proste już dla kilkuletniego dziecka – tutaj rozwój następuje bardzo powoli. Dopiero od niedawna ilość danych i technologia pozwala na stopniowy rozwój w tym obszarze, co pokazuje chociażby przykład firmy Boston Dynamics, zajmującej się robotyką [6].

Efekt Streisand

Kolejne zjawisko, na którym się skupimy to efekt Streisand. Głosi ono, iż im bardziej staramy się usunąć bądź ocenzurować jakąś informację w Internecie, tym większy zyskuje ona rozgłos i zainteresowanie. Efekt ten zawdzięcza swoją nazwę Barbrze Streisand i sytuacji z 2003 roku, gdy fotograf Kenneth Adelman wykonywał zdjęcia wybrzeża Kalifornii, w celu udokumentowania postępującej erozji [7]. Fotografie te zostały upublicznione na stronie poświęconej tematowi erozji wybrzeża. Zbiegiem okoliczności na jednym ze zdjęć widoczna była rezydencja Barbry Streisand. Pozwała ona fotografa za naruszenie prywatności, żądając odszkodowania i usunięcia fotografii, gdyż nie chciała, by ktokolwiek ją zobaczył. Sytuacja potoczyła się jednak całkiem nie po jej myśli – przegrała proces sądowy i musiała zwrócić fotografowi koszty, zaś fotografia nie tylko nie została usunięta, lecz zyskała jeszcze większy rozgłos i o wiele więcej wyświetleń niż przed całym zamieszaniem.

Efekt ten można tłumaczyć na kilka sposobów, opierających się w głównej mierze na ludzkiej psychologii, roli mediów społecznościowych oraz ogólnym mechanizmom obiegu informacji w sieci. Ludzie bardzo niechętnie znoszą wszelkie ograniczenia narzucone na ich wolność, również w zakresie dostępu do informacji. Często w sytuacjach wymuszonej cenzury ludzie celowo działają na przekór – chcą zdobyć jak najwięcej wiadomości na temat “zakazanej” informacji, chętnie się nią dzielą i udostępniają dalej. Podobnie działa mechanika “zakazanego owocu” – przez próbę ukrycia informacja wydaje się jeszcze ciekawsza i bardziej intrygująca, mimo że bez owej próby wiadomość prawdopodobnie przeszłaby bez echa. W dzisiejszych czasach, z racji łatwości dostępu do informacji i mnogości różnych mediów, wiadomości są powszechne i szybko mogą stać się viralem, przyciągając ogromne ilości odbiorców. Internet również zmienił nieco odbiór różnych treści. Fakt, iż każdy użytkownik może treść zapisać, udostępnić, w teorii uniemożliwia usunięcie czegoś z sieci, gdy już raz tam trafiło. Dodając do tego fakt, jak szybko media wychwytują i nagłaśniają przypadki cenzury, staje się dość oczywiste, dlaczego próba ukrycia czy zamaskowania czegoś kończy się zazwyczaj odwrotnym skutkiem.

Istnieje wiele przykładów efektu Streisand. W 2013 roku po występie na Super Bowl zespół do spraw wizerunku wokalistki Beyonce uznał jedno ze zdjęć za szczególnie niekorzystne i podjął próby usunięcia go z sieci. Efekt był dokładnie przeciwny, fotografia stała się dużo bardziej rozchwytywana niż pierwotnie, zaczęła służyć również jako szablon do internetowych memów. Nie brak też przypadków ze świata technologii. W 2007 roku jeden z użytkowników internetowego serwisu Digg ujawnił, iż system ochrony praw autorskich Advanced Access Content System (AACS) używany w odtwarzaczach HD DVD może być złamany ciągiem znanym jako 09 F9. Przedstawiciele przemysłu wykorzystującego to zabezpieczenie zażądali usunięcia wpisu na Digg i grozili konsekwencjami prawnymi. W efekcie w Internecie rozgorzały wielkie dyskusje, a informacja o kodzie (który przez chwilę był nazywany “najbardziej znanym numerem w Internecie”) mocno się rozprzestrzeniła i była powielana w postaci filmów, nadruków na koszulkach czy nawet piosenek [8].

Podsumowanie

Omówione w artykule zjawiska pokazują, że chociaż technologie, takie jak Sztuczna Inteligencja i Internet są potężnymi narzędziami, to mogą zniekształcać ludzką percepcję i tworzyć mylne wrażenia. Łatwo jest wpaść w rozmaite pułapki związane z technologią, dlatego świadomość wspomnianych zjawisk jest ważna, gdyż pozwala na bardziej krytyczne podejście do interakcji z technologią i informacją, lepsze wykorzystanie ich potencjału oraz zdrowe i rozsądne korzystanie z nich.

Bibliografia

[1] https://web.stanford.edu/class/cs124/p36-weizenabaum.pdf

[2] https://modelthinkers.com/mental-model/eliza-effect

[3] https://builtin.com/artificial-intelligence/eliza-effect

[4] https://www.humanprotocol.org/blog/what-is-the-eliza-effect-or-the-art-of-falling-in-love-with-an-ai

[6] https://www.scienceabc.com/innovation/what-is-moravecs-paradox-definition.html

[7] https://www.forbes.com/2007/05/10/streisand-digg-web-tech-cx_ag_0511streisand.html

[8] https://web.archive.org/web/20081211105021/http://www.nytimes.com/2007/05/03/technology/03code.html